Einstellungstests/Eignungstests

Warum psychologische Tests bei der Anwerbung neuer Mitarbeiter und bei der Karriereberatung?

In einem sehr bekannten Artikel stellten Frank L. Schmidt & John E. Hunter (1998) die Ergebnisse einer groß angelegten sog. Metaanalyse in der Zeitschrift „Psychological Bulletin“ vor. Metaanalysen sind Untersuchungen, die Ergebnisse vieler einzelner Untersuchungen zusammenfassen. Der Titel des Artikels lautet „The Validity and Utility of Selection Methods in Personnel Psychology: Practical an Theoretical Implication of 85 Years of Research Findings“. Ziel dieser Metaanalyse war die prognostische Validität (das Vorhersagevermögen) verschiedener Auswahlverfahren bei der Personalbeschaffung, also die Erhebung, mit welcher Wahrscheinlichkeit die berufliche Leistung von Personen mit Hilfe der jeweiligen Auswahlverfahren vorhergesagt werden kann.

Die Ergebnisse waren folgende (die Validitätswerte entsprechen Korrelationskoeffizienten, d. h. bei 1.0 besteht ein vollständig positiver Zusammenhang zwischen den betrachteten Merkmalen; bei 0.0 besteht überhaupt kein Zusammenhang, kann die Methode die berufliche Leistung also überhaupt nicht vorhersagen):

- GMA tests: .51

- Work sample tests: .54

- Integrity tests: .41

- Conscientiousness tests: .31

- Employment interviews (structured): .51

- Employment interviews (unstructured): .38

- Job knowledge tests: .48

- Job tryout procedure: .44

- Peer ratings: .49

- T & E behavioral consistency method: .45

- Reference checks: .26

- Job experience (years): .18

- Biographical data measures: .35

- Assessment centers: .37

- T & E point method: .11

- Years of education: .10

- Interests: .10

- Graphology: .02

- Age: .01

Zusammenfassend lässt sich sagen, dass Schmidt & Hunter entweder GMA-Tests (= IQ-Tests) plus ein strukturiertes Interview oder GMA-Tests plus Integritätstests empfehlen. Dabei können Integritätstests als Persönlichkeitstests betrachtet werden, die eine Mischung der Eigenschaften Gewissenhaftigkeit, Verträglichkeit und Stabilität messen.

Laut der Forschung empfiehlt es sich also psychologische Testverfahren zu nutzen, um die Prognosen der beruflichen Leistung zu optimieren. Wie Schmidt & Hunter – und viele andere Forscher – zeigen, können durch den Einsatz von Testverfahren beträchtliche Vorteile erzielt werden.

Wie werden die Testverfahren eingesetzt?

Der eignungsdiagnostische Prozess

In diesem Kapitel geht es um die Darstellung der verschiedenen Schritte des eignungsdiagnostischen Prozesses. Der Test findet nicht nur Anwendung in der Personalauswahl, sondern auch in der Karriereberatung.

Gulden (1996) schlägt u.a. ein dreistufiges Modell vor das nicht so viel Zeit und Arbeitsaufwand beansprucht. Dies dürfte die Hauptursache für seinen häufigen Einsatz in der Praxis sein.

| 1 | Arbeits- und Anforderungs-analyse | |

| ↓ | ||

| 2 | Rückgriff auf Erkenntnisse von Metaanalysen bzgl.Validität und Nützlichkeit | |

| ↓ | ||

| 3 | Entscheidungsmodell für Selektion/Plazierung |

Verkürztes dreistufiges Phasenmodell zur Personalauswahl (nach Gulden, 1996, S. 178)

Unten wird ein Überblick über die Modelle und Verfahren gegeben, die beim jeweiligen Schritt von besonderer Bedeutung sind.

Arbeits- und Anforderungsanalyse

Eine gut begründete Entscheidung setzt nicht nur Wissen über die Leistungsvoraussetzungen der Person voraus, sondern genauso Wissen über die Anforderungen der Situation. Um dieses Wissen zu erwerben, werden Arbeits- und Anforderungsanalysen (AA) durchgeführt.

Schuler & Funke (1993) stellen eine Kategorisierung der Arbeitsanalyseverfahren vor, die sich nach drei generellen Beschreibungsebenen für Anforderungen orientiert. Die drei Ebenen sind: Aufgabenebene, Verhaltensebene und Eigenschaftsebene.

Die aufgabenorientierten AA beschreiben schwerpunktmäßig den Arbeitsinhalt durch eine möglichst präzise und umfassende Darstellung der auszuführenden Tätigkeiten. Die für diesen Zweck am häufigsten eingesetzten AA-Verfahren sind die sog. Aufgabeninventarien (task inventories, TI). TIs werden normalerweise den Arbeitsplatzinhabern oder deren Vorgesetzten gegeben. Sie bestehen aus einer Liste mit oft mehreren hundert Arbeitsaufgaben/-tätigkeiten. Jede Arbeitsaufgabe/-tätigkeit soll auf Ratingskalen bewertet werden, z.B. wie wichtig, wie schwierig oder wie häufig vorkommend sie ist. Die TIs sind nur sehr begrenzt auf andere Arbeitsplätze übertragbar, d.h. sie müssen meistens für den jeweiligen Arbeitsplatz speziell konstruiert werden. Für die Auswahl bzw. Konstruktion von eignungsdiagnostischen Verfahren gewinnen die TIs vor allem dort an Bedeutung, wo es um die Auswahl von Arbeitsaufgaben in Aufgabensimulationen geht. Es werden z.B. nur die Aufgaben simuliert, die mit Hilfe des TIs als besonders wichtig identifiziert worden sind. Mit Hilfe der TIs lassen sich auch Kriterien für Leistungsbeurteilungen gut ableiten.

Bei verhaltensorientierten AA wird schwerpunktmäßig der prozessuale Aspekt des Verhaltens bei der Arbeitsausführung beachtet. Als Beispiele für solche AA-Verfahren nennen Schuler & Funke (1993) die „Methode kritischer Ereignisse“ (Critical Incident Technique, CIT) von Flanagan (1954), den „Fragebogen zur Arbeitsanalyse“ (FAA) von Frieling & Hoyos (1978) und das „Tätigkeits-Analyse-Inventar“ (TAI) von Frieling, Facaoaru, Benedix, Pfaus & Sonntag (1990). Die CIT ist das älteste AA-Verfahren (Cook, 1993), sie ist eine arbeitsplatz- bzw. aufgabenspezifische Methode. Die Datenerhebung wird von Arbeitsplatzexperten durchgeführt und erfolgt über Interviews, Workshops und/oder Fragebögen. Es wird nach sog. „kritischen Ereignissen“ gesucht. Das sind Verhaltensweisen, die bei der Erledigung der anfallenden Aufgaben als besonders erfolgreich bzw. besonders erfolglos zu beurteilen sind. Die so ermittelten „kritischen“ Verhaltensweisen sind oft sehr zahlreich und müssen deswegen zu allgemeineren Verhaltensanforderungen zusammengefasst werden. Eine im Beruf erfolgreiche Person muss in der Lage sein, diese geforderten Verhaltensweisen zu zeigen. Kompa (1993) stellt als Beispiel für eine in dieser Weise gewonnene Liste mit Verhaltenskategorien eine Auflistung von Dunette (1966) vor. Ein erfolgreicher Verkaufsleiter muss folgendes können: „1. Following up a) on customer complaints, b) on special requests, c) on orders, d) on leads for new buisness. 2. Planning ahead. 3. Communicating important information to sales manager…“ usw. (S. 80)

Eine arbeitsplatzübergreifende Methode, ist der Fragebogen zur Arbeitsanalyse (FAA) von Frieling & Hoyos (1978). Der FAA ist eine deutsche Version des Position Analysis Questionnaire (PAQ) von Mc Cormick & Jeanneret (1988) und ist ein vollstrukturiertes Beobachtungsinterview. Während der PAQ sechs allgemeingültige Hauptsektionen des menschlichen Arbeitsverhaltens erfasst, begnügt sich der FAA mit vier. Diese sind: 1. Informationsaufnahme und Informationsverarbeitung (66 Items), 2. Arbeitsausführung (51 Items), 3. Arbeitsrelevante Beziehungen (50 Items) und 4. Umgebungseinflüsse und besondere Arbeitsbedingungen (54 Items) (Weinert, 1987). Die Items sind einzelne Arbeitselemente, die häufig in verschiedenen Berufen anzutreffen sind. Die Ergebnisse der FAA sind verhaltensbezogen, werden aber für eignungsdiagnostische Zwecke als Basis für die Ableitung von Eigenschaftsanforderungen benutzt.

Ein Verfahren, das sich auf die kognitiven Anforderungen des Arbeitsplatzes konzentriert, ist das umfangreiche Tätigkeits-Analyse-Inventar (TAI) von Frieling, Facaorau, Benedix, Pfaus & Sonntag (1990).

Die eigenschaftsorientierten AA-Verfahren beschreiben einen Arbeitsplatz anhand der Eigenschaften des Arbeitsplatzinhabers. Der Arbeitsplatzinhaber muss gewisse Persönlichkeitseigenschaften, Fertigkeiten und Interessen besitzen, um die Arbeitsaufgaben erfolgreich bewältigen zu können. Schuler & Funke (1993) unterscheiden zwischen einem holistischen und einem dekomponierenden Vorgehen. Beim holistischen Vorgehen wird der Arbeitsplatz als Ganzes betrachtet, und danach wird direkt auf notwendige Eigenschaften geschlossen. Beim dekomponierenden Vorgehen wird zunächst eine aufgaben- oder verhaltensorientierte AA durchgeführt (z.B. der FAA), danach schließt man unter Zuhilfenahme von Expertenurteilen auf die erforderlichen Eigenschaften und Eigenschaftsausprägungen.

Für den Eignungsdiagnostiker sind meist die Eigenschaftsanforderungen von besonderer Bedeutung, weil psychologische Tests normalerweise für Messungen auf dieser Ebene zugeschnitten sind. Einen „Kurzweg“ zur Ermittlung der Eigenschaftsanforderungen stellen statistische Verfahren der Merkmalsanalyse dar (vgl. Hossiep, 1995). Man kann z.B. die in einem Beruf Tätigen testen und deren durchschnittliche Eigenschaftsprofile als Vorbild für Bewerber benutzen. Statt durchschnittliche Stelleninhaber abzubilden, kann man Durchschnittsprofile von besonders guten bzw. besonders schlechten Stelleninhabern ermitteln. Je exakter das Berufserfolgskriterium ist, desto genauer kann der Zusammenhang zwischen Eigenschaften und Berufserfolg ermittelt werden. Das Gleiche gilt für die Genauigkeit der Eigenschaftsurteile.

In der eignungsdiagnostischen Praxis wird man sich bei der Bestimmung und Auswahl von Prädiktoren am häufigsten auf statistische Verfahren und globale Ratings beschränken (Hossiep, 1995).

AA bringen Vorteile für die Personalarbeit im Allgemeinen und für die Eignungsdiagnostik im besonderem. Cook (1993) zählt 13. Vorteile auf, im Folgenden einige davon:

- Inhaltsvalidität: Weiß man durch die AA, welche Arbeitstätigkeiten besonders wichtig für einen Arbeitsplatz sind, kann man Tests mit einem hohen Maß an Inhaltsvalidität konstruieren.

- Synthetische Validierung: Kann man allgemeine Beschreibungsfaktoren für mehrere Arbeiten finden, so lassen sich ganz verschiedene Arbeiten mit denselben Faktoren beschreiben. Hat man außerdem für jeden Faktor einen validen Test, kann durch die AA eine valide Test(-batterie) direkt ausgewählt werden.

- Die AA hilft bei der Formulierung präziser Arbeitsbeschreibungen.

- Die AA identifiziert ähnliche Arbeitsplätze. Bewirbt sich z.B. eine Person für Arbeitsplatz A, und ist dieser schon besetzt, können andere Arbeitsplätze vorgeschlagen werden, die den Tätigkeiten und Anforderungen von A sehr ähnlich sind.

- Für die Entwicklung von Arbeitserfolgs-Kriterien (z.B. für Personalbeurteilungssysteme) ist die AA hilfreich, weil sie darstellt, worauf es bei der Arbeit wirklich ankommt.

Schuler & Funke (1993) nennen drei größere Probleme und Kritikpunkte im Zusammenhang mit AA:

- Schlecht definierbare Arbeitsaufgaben: Die Arbeitsaufgaben einer Person ändern sich oft schnell. Entweder weil neue oder andere Arbeitsaufgaben dem Arbeitsplatz hinzugefügt oder weggenommen werden, oder weil die Person der Arbeitsplatz wechselt. Eine (Teil-)Lösung besteht in einer „Potentialdiagnose“, bei der nur Eigenschaften gemessen werden, die (fast) generell als berufserfolgsrelevant zu beurteilen sind.

- Inhaltliche und methodische Defizite: Anforderungen wie z.B. „soziale Kompetenz“ sind normalerweise schwierig zu beurteilen. Zum Teil laufen die Schritte von der Beobachtung des Arbeitsplatzes bis zur Auswahl der eignungsdiagnostischen Instrumente verdeckt ab. Auch Experten können durchaus Fehler machen. Das Problem macht deutlich, dass die AA-Verfahren, genau wie psychologische Tests im engeren Sinn, den Gütekriterien Objektivität, Reliabilität und Validität genügen müssen.

- Ökonomie: Ausführliche AA nehmen viel Zeit und Ressourcen in Anspruch und werden deshalb meistens nur bei der Neukonstruktion von eignungsdiagnostischen Verfahren durchgeführt. Methoden wie globale Schätzverfahren oder statistische Verfahren zur Merkmalsanalyse sind weniger aufwendige Alternativen.

Eine Alternative zu traditionellen Anforderungsanalysen: Validitätsgeneralisierung

Am Anfang des Textes wurde eine Metaanalyse vorgestellt, die der Frage nachging welche diagnostischen Methoden (z.B. Arbeitsproben, IQ-Tests, Assessment Centers usw.) die besten Prognosen der beruflichen Leistung machen. Es gibt aber auch Metaanalysen, die versuchen herauszufinden welche Eigenschaften für verschiedene „prototypsche“ Berufe besonders wichtig sind für den Berufserfolg im aktuellen Beruf.

So haben z.B. Judge, et al. (2002) herausgefunden, dass für Manager die Persönlichkeitseigenschaft Extraversion besonders beachtet werden sollte. Bei Verkäufer finden Hough (1997) und Vinchur et al. (1998), dass Aspekte wie Extraversion und Gewissenhaftigkeit besonders entscheidend sind. Für viele Berufe scheint der Persönlichkeitsfaktor Gewissenhaftigkeit positiv auf den Berufserfolg zu wirken, wobei meistens der g-faktor (GMA/IQ) noch wichtiger ist (Schmidt & Hunter, 2004).

Es ist selbstverständlich ein sehr viel einfacherer Weg, das Anforderungsprofil, zumindest bzgl. der eigenschaftsbasierten Kompetenzen einer Position, nach den Ergebnissen von Metaanalysen zu richten anstatt eine traditionelle Anforderungsanalyse durchzuführen. Ein Nachteil mit auf Metaanalysen basierten Anforderungsprofilen ist, dass die „Analyse“ gröber und schablonenmäßig wird.

Kombination der Prädiktordaten

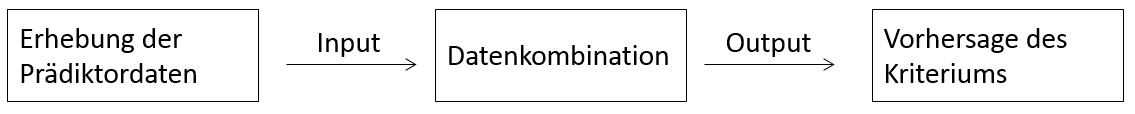

Geht man nun davon aus, dass mehrere valide Prädiktoren und eine Reihe von Bewerbern vorhanden sind, die alle Scores auf den verschiedenen Prädiktoren haben, so steht man vor der Frage, wie die Skalen-Scores jeder einzelnen Person kombiniert werden sollen, um eine maximal gültige Vorhersage des Kriteriums zu bekommen. Wiggins (1973) hat ein einfaches Modell entworfen, das die Phasen der Kriteriumsprognose darstellt.

Die Phasen der Kriteriumsprognose (Wiggins, 1973, Übersetzung in Anlehnung an Kompa, 1989, S. 76)

Im Schritt „Erhebung der Prädiktordaten“ unterscheidet Wiggins (1973) zwischen „beurteilender Messung“ (judgemental measurement) und „mechanischer Messung“ (mechanical measurement). Bei beurteilender Messung spielen menschliche Urteilsprozesse eine Rolle bei der Datenerhebung. Beurteilende Messung kann durchaus numerische Größen generieren, Hauptmerkmal ist jedoch, dass diese Zahlen Produkte subjektiver Urteilsprozesse im Kopf des Diagnostikers sind. Beispiele sind Interview-Ratings.

Bei der mechanischen Messung finden keine subjektiven Urteilsprozesse statt, sondern die Datenerhebung verläuft standardisiert und objektiv, von den Fragen bis zur Verteilung der (Skalen-) Punktwerte. Beispiele sind Intelligenztests und Persönlichkeitsfragebögen mit vorgegebenen Antwortalternativen.

Die Daten aus der beurteilenden oder mechanischen Messung machen den Input für die Datenkombination aus. Bei der Datenkombination bekommen die verschiedenen Prädiktoren unterschiedliche Gewichte, und werden anschließend linear oder nichtlinear, kompensatorisch oder nichtkompensatorisch kombiniert (s. unten). Welches Gewicht ein Prädiktor bekommt, sollte davon abhängen, wie stark er mit dem Kriterium korreliert ist, bzw. wie groß sein eigenständiger Beitrag zur Vorhersage des Kriteriums ist.

Es wird unterschieden zwischen klinischer und statistischer Datenkombination. Bei der klinischen Datenkombination nimmt der Kliniker (Diagnostiker) die Prädiktorinformationen auf, verarbeitet sie subjektiv und macht anschließend eine Prognose über die künftige Kriteriumsausprägung. Ähnlich wie bei der beurteilenden Messung spielen subjektive Urteilsprozesse also eine entscheidende Rolle.

Bei der statistischen Datenkombination wird ein mathematisches Modell aufgestellt, das festlegt, wie die Prädiktorwerte zu kombinieren sind, d.h. welche Gewichte die einzelnen Prädiktoren haben sollen und wie sie danach zu einem (Prognose-) Wert zusammengefasst werden. Dabei kann man statistische Methoden benutzen, um ein „optimales Modell“ aufzustellen. Dieses „optimale Modell“ kann z.B. in der Untersuchungsstichprobe mit Hilfe einer multiplen Regressionsberechnung ermittelt werden. Die quadrierte Abweichung der beobachteten Kriteriumswerte von der Regressionsgeraden (die vorhergesagten Werte), wird dabei minimiert (s. z.B. Backhaus, Erichson, Plinke & Weiber, 1994).

Inwiefern die statistische Datenkombination der klinischen Datenkombination über- oder unterlegen ist, wurde kontrovers diskutiert (s. Wiggins, 1973). In Bezug auf die Datenkombination wird von den Kritikern der klinischen Urteilsbildung behauptet, der Kliniker sei bestenfalls eine „second-rate IBM machine“. (s. Wiggins, 1973, S. 146). Die Argumentation ist dabei folgende: Weil die Datenkombination mathematisch so modelliert werden kann, dass die Vorhersage des Kriteriums automatisch so gut wie möglich gelingt, kann der Kliniker sich dieser „optimalen“ Datenkombination nur annähern. Die Verteidiger der klinischen Datenkombination halten dagegen, indem sie z.B. argumentieren, dass a) der Kliniker es mit individuellen Fällen und nicht mit Entscheidungen über Gruppen zu tun hat, b) der Kliniker einmalige Muster in der Prädiktorinformation erkennen und diese in seiner Prognose berücksichtigen kann und c) der Kliniker fast immer über zusätzliche Informationen verfügt, die sich im mathematischen Modell nicht integrieren lassen. Die Kritiker der klinischen Urteilsbildung antworten darauf, dass das, was ein Kliniker bei der Datenkombination macht, auch ein Computer durch entsprechende Programmierung leisten kann (s. Wiggins, 1973).

Die Diskussion über die Güte statistischer vs. klinischer Datenkombination wurde durch Meehls (1954) berühmte „Box-Scores“ angefacht. Die „Box-Scores“ fassten die Ergebnisse aus 20 Untersuchungen zusammen, in denen statistische und klinische Vorhersagen miteinander verglichen wurden. Meehl fand heraus, dass generell die Ergebnisse zugunsten statistischer Vorhersage sprachen. Seine Befunde regten viel Forschungstätigkeit auf diesem Gebiet an und 1965 konnte Meehl die Ergebnisse aus 51 Studien zusammenfassen. 33 Studien zeigten eine Überlegenheit statistischer Vorhersage, in 17 Studien schnitten beide Vorhersagemethoden etwa gleich gut ab und in einer Untersuchung wurde eine Überlegenheit für klinische Urteilsbildung nachgewiesen. Diese letztgenannte Untersuchung war aber schlecht durchgeführt und musste als „gleich gut“ reklassifiziert werden.

Eine interessante Untersuchung ist von Sawyer (1966) durchgeführt worden. Sawyer hat 45 Untersuchungen, zum großen Teil von Meehl, reanalysiert. Dabei hat er zwischen Messung und Datenkombination (s. Abbildung 6) unterschieden, so dass er diese Faktoren systematisch variieren konnte. Es entstanden acht Klassen von Prognosemethoden (s. Kompa, 1989):

- Die rein klinische Methode: Klinische (=beurteilende) Messung und klinische Datenkombination. Beispiel: Eine Einstellungsentscheidung auf Grundlage eines Einstellungsinterviews und einer Analyse der Bewerbungsunterlagen.

- Eigenschaftsbeurteilung: Klinische Messung und mechanische Datenkombination. Beispiel: Interviewratings werden nach festgelegten mathematischen Regeln kombiniert.

- Profilinterpretation: Mechanische Messung und klinische Datenkombination. Beispiel: Mittels Persönlichkeitsfragebogen erhobene Persönlichkeitsprofile werden vom Diagnostiker ohne Zuhilfenahme objektiver Kombinationsregeln interpretiert.

- Rein statistische Vorhersage: Mechanische Messung und mechanische Datenkombination. Beispiel: Werte aus Persönlichkeits- und Leistungstests werden nach empirisch ermittelten Kombinationsregeln kombiniert.

- Die klinisch zusammengesetzte Methode: Klinische plus mechanische Messung und klinische Datenkombination. Beispiel: Der Diagnostiker hat Zugang zu Werten aus Persönlichkeits- und Leistungstests sowie Eindrücke aus einem Interview. Diese Daten werden vom Diagnostiker subjektiv kombiniert.

- Die mechanisch zusammengesetzte Methode: Klinische plus mechanische Messung und mechanische Datenkombination. Beispiel: Werte aus Persönlichkeits- und Leistungstests plus Interviewratings werden mit Hilfe mathematischer Modelle kombiniert.

- Die klinische Synthese: Klinische und/oder mechanische Messung wird mechanisch kombiniert und die daraus stammende Kriteriumsprognose wird dem Diagnostiker vorgelegt. Der Diagnostiker hat außer dieser statistisch gewonnenen Kriteriumsprognose auch direkten Zugang zu den Daten aus den Messungen. Die endgültige Kriteriumsprognose wird aber klinisch vom Diagnostiker gemacht, d.h. er kann selber entscheiden, in welchem Ausmaß er der statistisch gewonnenen Kriteriumsprognose folgt.

- Die mechanische Synthese: Klinische und/oder mechanische Messung wird dem Diagnostiker zu Verfügung gestellt. Er macht auf dieser Grundlage eine Kriteriumsprognose. Diese Prognose, zusammen mit den Rohdaten aus der klinischen und/oder mechanischen Messung, dient als Input für eine mathematische Gleichung, d.h. eine mechanische Datenkombination.

In der Tabelle unten sind die Ergebnisse aus der Reanalyse von Sawyer (1966) zusammengefasst.

Ergebnisse aus Sawyers (1966) Reanalyse von 45 Untersuchungen, in denen klinische und statistische Vorhersagen miteinander verglichen werden

| ART DER MESSUNG | ART DER DATENKOMBINATION | |

| KLINISCH | MECHANISCH | |

| KLINISCH | 1. rein klinische (20%) | 2. Eigenschaftsbeurt. (43%) |

| MECHANISCH | 3. Profilinterpretation (38%) | 4. rein statistische (63%) |

| BEIDE | 5. klin. zusammeng. (26%) | 6. mech. zusammeng. (75%) |

| EINE O. BEIDE | 7. klin. Synthese (50%) | 8. mech. Synthese (75%) |

Die Prozentzahlen wurden hierbei folgendermaßen ermittelt: Für jede Vorhersagemethode (z.B. „rein statistische“) hielt Sawyer fest, wieviele Male diese Vorhersagemethode beim Vergleich mit anderen Vorhersagemethoden überlegen war. Danach teilte er die Anzahl Vergleiche, bei denen die Vorhersagemethode gleich gut war durch zwei und addierte diese Zahl mit der Anzahl Vergleiche, bei der die Vorhersagemethode überlegen war. Die Summe wird durch die gesamte Anzahl durchgeführter Vergleiche geteilt. Beispiel: 41-mal wurde die rein statistische Methode mit anderen Methoden verglichen. 11-mal war sie besser als die Vergleichsmethode und 30-mal war sie gleich gut. Niemals war sie schlechter. Der berechnete Wert lautet: (11+(30/2)) / 41 = 63%.

Die Werte in Tabelle 3 müssen mit Vorsicht interpretiert werden, da die Prozentzahlen aus Vergleichen zwischen jeweils unterschiedlichen Methoden stammen. Außerdem ist die Anzahl Vergleiche, die einer Prozentzahl bilden, unterschiedlich groß. Trotzdem zieht Wiggins (1973) gewisse Schlüsse:

- Für jede Messmethode (linke Spalte in Tabelle 3) ist die mechanische (=statistische) Datenkombination der klinischen Datenkombination überlegen.

- Die klinische (=beurteilende) Messung ist die schwächste Quelle für Prädiktordaten, unabhängig von der Art der Datenkombination.

- Mit Ausnahme der „klinisch zusammengesetzten Methode“ gibt es einen Trend, dass eine Datenbank mit mechanischen und klinischen Daten der ungemischten Datenbank überlegen ist.

- Die effektivste Methode der klinischen Datenkombination ist die „klinische Synthese“, wobei man beachten muss, dass diese verhältnismäßig umständliche Methode jeder mechanischen Datenkombinationsmethode mit mechanischen Daten unterlegen ist.

- Die „mechanisch zusammengesetzte Methode“ und die „mechanische Synthese“ sind die effektivsten Methoden. Da sie gleich gut abschneiden, liegt der Schluss nahe, dass bei der „mechanischen Synthese“ der Computer dem Urteil des Diagnostikers kaum Gewicht bemisst.

- Das auffälligste Ergebnis von Sawyer`s Untersuchung ist die Überlegenheit der „mechanisch zusammengefassten Methode“. Es soll betont werden, dass diese Methode nicht nur sämtlichen klinischen Datenkombinationsmethoden, sondern auch mechanischen Methoden ohne klinische Messung überlegen ist. Daraus kann man schließen, dass der Diagnostiker als „Daten-Sammler“ durchaus Dienste leisten kann und auch soll, die Datenkombination aber vom Computer ausgeführt werden sollte.

Wenn die statistische Datenkombination überlegen ist, warum wird sie dann in der Praxis nicht öfter praktiziert als dies der Fall ist? Amelang & Zielinski (1994) meinen, es hängt vom Fehlen großer Untersuchungsgruppen ab. Um empirisch fundierte statistische Kombinationsmodelle zu ermitteln braucht man erst große Stichproben, bei denen Prädiktor- und Kriteriumswerte vorhanden sind. Bei vielen kleineren und mittleren Organisationen sind solche Stichproben nicht vorhanden. Die Ergebnisse neuerer Untersuchungen sprechen für eine Generalisierbarkeit der prognostischen Validitäten vieler Prädiktoren (Schmidt & Hunter, 1998). Es öffnet sich die Möglichkeit in der betrieblichen Auslesepraxis auch von generalisierten Prädiktorgewichten Gebrauch zu machen. In solchen Fällen könnte man die statistische Datenkombination auch bei Personalauswahl in kleineren Unternehmen einführen.

Es gibt eine Alternative zu der oben beschriebenen statistischen Datenkombination, die auch eine mathematische Vorhersage des Kriteriums ermöglicht. Wiggins (1973) berichtet über verschiedene Möglichkeiten eine „automatisierte klinische Vorhersage“ zu konstruieren. So kann man z.B. den Kliniker beim Interpretieren von Persönlichkeitsprofilen bitten, laut zu denken und später versucht man, die geäußerten Entscheidungsmodelle des Klinikers mathematisch nachzumodellieren.

In der nächsten Phase des eignungsdiagnostischen Prozesses muss man sich fragen, welches Treatment (z.B. Einstellung oder Ablehnung) einer Person letztendlich zugeordnet werden soll. Außerdem kann man sich fragen, ob wirklich bei allen Bewerbern sämtliche Prädiktorinformationen erhoben werden sollen, oder ob man z.B. eine Vorauswahl macht. Zur Beantwortung solcher Fragen werden nun verschiedene Entscheidungsstrategien vorgestellt.

Die Entscheidungsstrategien für Treatments (Einstellung oder Ablehnung) unterscheiden sich hinsichtlich zweier wichtiger Dimensionen: Sie können kompensatorisch oder konjunktiv und sie können einstufig oder mehrstufig sein.

Bei einer linearen Kombination von Prädiktorwerten (wie z.B. bei einer linearen Regression), geht man implizit von einem sog. kompensatorischen Modell aus. Dabei wird angenommen, dass niedrige Werte auf einem Prädiktor durch hohe Werte auf einem anderen Prädiktor ausgeglichen (kompensiert) werden können.

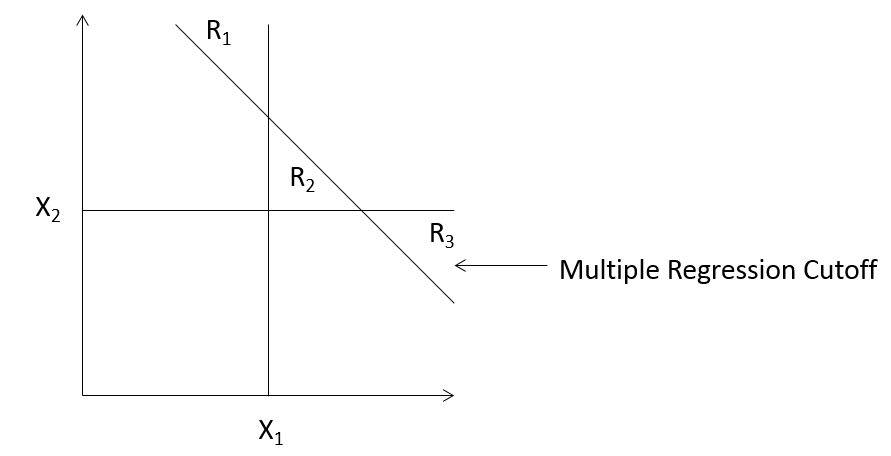

In gewissen Situationen können aber mangelnde Fähigkeit in einem Bereich nicht einfach durch sehr gute Fähigkeiten in einem anderen Bereich kompensiert werden. Mangelnde Sehtüchtigkeit eines Bewerbers für eine Pilotenausbildung, kann z.B. nicht durch ein noch so gutes Konzentrationsvermögen kompensiert werden. Die Entscheidungsstrategie der Wahl wäre hier eine konjunktive, d.h. eine „Und-Strategie“ (Sehtüchtigkeit und Konzentrationsvermögen). Bei konjunktiven Strategien werden „cutoffs“, d.h. notwendige Mindestausprägungen für jeden Prädiktor, festgelegt. Ein solches Modell mit mehreren „cutoff“-Werten wird auch „multiples cutoff“-Modell genannt. In der Abbildung unten werden die Konsequenzen der beiden Strategien dargestellt.

Entscheidungen auf Grundlage multipler Regression vs. multipler Cutoff-Technik (nach Thorndike, 1949)

Die Abbildung zeigt ein einfaches Beispiel mit zwei Tests X1 und X2. Die horizontalen und vertikalen Striche sind die Testcutoffs. Gemäß dem konjunktiven Modell werden alle Personen angenommen, die rechts vom X1-Cutoff liegen und über dem X2Cutoff. Die schräge Linie stellt die Multiple-Regressions-Cutoff dar. Alle Personen, die über dieser Linie liegen, werden angenommen. Es ist ersichtlich, dass gewisse Personen, die vom kompensatorischen Modell (multiple Regression) angenommen werden, vom konjunktiven Modell abgelehnt werden und umgekehrt. Die Personen im Bereich R1 und R3 werden vom kompensatorischen Modell angenommen, aber vom konjunktiven Modell abgelehnt. Die Personen im Bereich R2 werden vom konjunktiven Modell angenommen, aber vom kompensatorischen Modell abgelehnt.

Die zweite wichtige Dimension bei Entscheidungsstrategien unterscheidet zwischen ein- und mehrstufige Strategien. Der Hauptunterschied ist, dass bei einstufigen Strategien der Bewerber getestet wird, und auf Basis dieser Testergebnisse endgültig angenommen oder abgelehnt wird. Bei mehrstufigen Strategien (auch sequentielle Strategien genannt), werden erst ein oder mehrere Tests durchgeführt und auf der Basis dieser ersten Ergebnisse zunächst Vorentscheidungen darüber getroffen, wie es mit den Bewerbern weitergehen soll. Im Unterschied zu einstufigen Verfahren wird nur für einen Teil der Personen terminale Entscheidungen getroffen. Für einen anderen Teil der Personen werden zunächst weitere Informationen gesammelt, bevor endgültig Entscheidungen getroffen werden.

Die einstufigen Entscheidungsstrategien lassen sich nach Amelang & Zielinski (1994) in „nichtsequentielle Batterien“ und „single screen“-Verfahren einteilen. Bei nichtsequentiellen Batterien werden sämtliche Bewerber mit mehreren Testverfahren getestet, und die mit den höchsten Gesamtscores werden angenommen. Bei single screen Verfahren wird das gleiche gemacht, nur wird keine Testbatterie, sondern ein einziger Test benutzt. Die sequentiellen Verfahren werden untergliedert in:

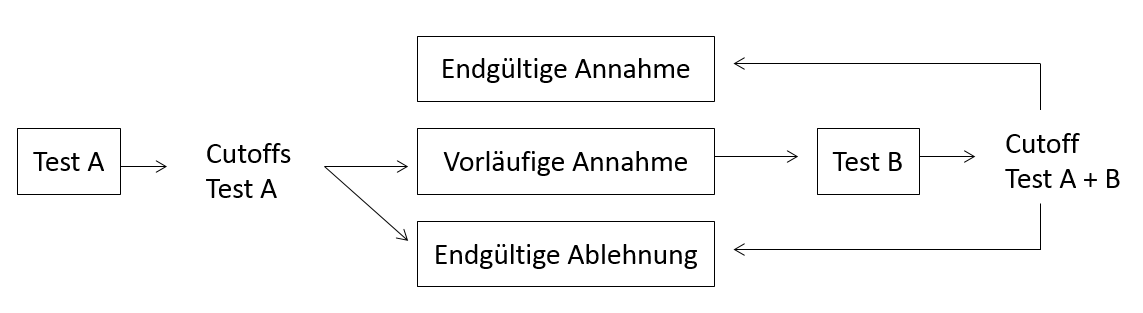

- Vorauswahl (pre reject) Strategie: Nach dem ersten Testdurchgang werden die Bewerber, die unter einem festgelegten Cutoff liegen, endgültig abgelehnt. Die Verbleibenden werden mit einem anderen Test ein zweites Mal getestet. Die endgültig Entscheidung über Annahme oder Ablehnung der verbleibenden Bewerber wird auf Basis des Abschneidens am Test eins und zwei getroffen. Die Abbildung unten zeigt eine Vorauswahlstrategie.

Vorauswahlstrategie (in Anlehnung an Wiggins, 1973)

- Vorentscheidungs- (pre accept) Strategie: Nach dem ersten Testdurchgang werden die Bewerber, die einem Cutoff-Wert übertreffen, endgültig angenommen. Alle anderen gehen zu einem zweiten Testdurchgang weiter. Die endgültige Entscheidung über Annahme oder Ablehnung dieser Bewerber wird auf Basis der Ergebnisse im Test eins und zwei getroffen. Die Abbildung unten zeigt eine Vorentscheidungsstrategie.

Vorentscheidungsstrategie

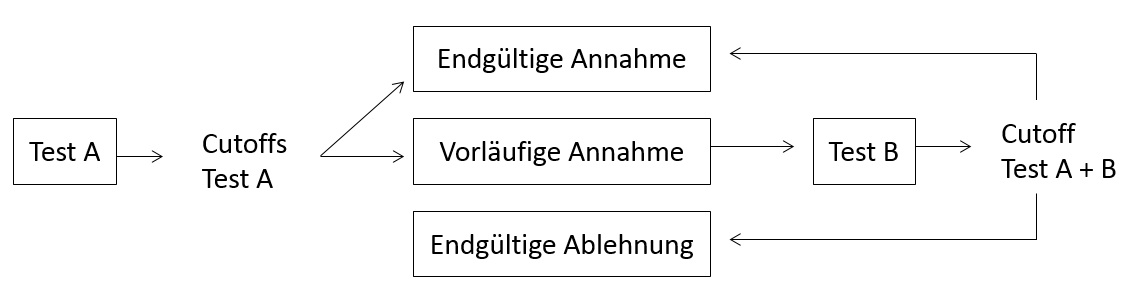

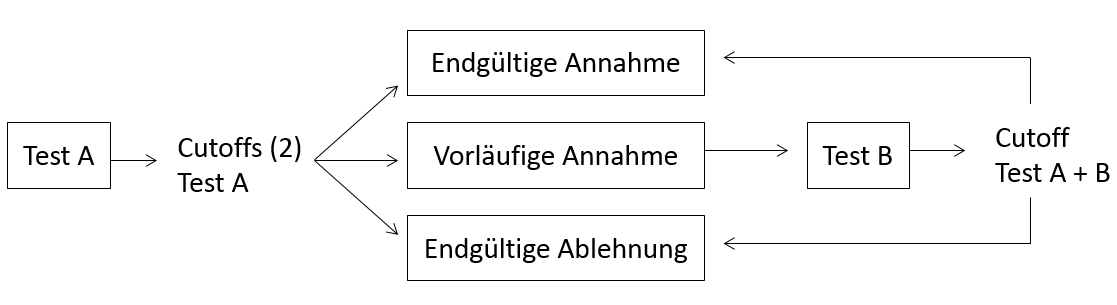

- Vollständige sequentielle Strategie: Beim ersten Testdurchgang werden zwei Cutoffs benutzt: Ein unterer Cutoff bei Test A entscheidet welche Bewerber endgültig abgelehnt werden sollen, ein oberer Cutoff bei Test A besagt welche Bewerber endgültig angenommen werden sollen. Die Bewerber, die zwischen den Cutoffs liegen gehen zu einer zweiten Testung weiter. Anhand der Ergebnisse aus Test A und B wird entschieden welche Bewerber von dieser Gruppe endgültig angenommen bzw. abgelehnt werden. Die Abbildung unten zeigt eine vollständige sequentielle Strategie.

Vollständige sequentielle Strategie (in Anlehnung an Wiggins, 1973)

Wiggins (1973) meint, es sei erlaubt zu sagen, dass die vollständige sequentielle Strategie den anderen sequentiellen Strategien meistens überlegen ist. Dieses treffe vor allem dann zu, wenn man die prognostische Validität und die Kosten der Durchführung beachtet. Aus demselben Grund sind sequentielle Verfahren den nicht-sequentiellen Verfahren vorzuziehen. Der Kostenvorteil bei sequentiellen Verfahren besteht darin, daß nicht alle Bewerber sämtliche Tests machen müssen. Bei einer vollständigen sequentiellen Strategie schöpft man die Validität des ersten Tests am effektivsten aus (Wiggins, 1973).

In der Praxis werden sehr häufig sequentielle Strategien verwendet. Zum Beispiel werden normalerweise erst die Bewerbungsunterlagen analysiert und danach ein Teil der Bewerber zum Interview eingeladen (Schuler, Frier & Kauffmann, 1993).