Intelligenztests/ IQ-Tests

Was messen Intelligenztests/IQ-Tests?

Die meisten Intelligenztestaufgaben haben gemein, dass sie abstrakt-logisches Denken abverlangen. Die Aufgaben können verbaler, numerischer oder figuraler (spatialer/räumlicher) Art sein:

Beispiel einer verbalen Testaufgabe:

Hand ist zu Arm, wie Fuß zu_____

a) Zehe

b) Knie

c) Bein

d) Schulter

Beispiel einer numerischen Testaufgabe:

Welche Zahl sollte die Reihe fortsetzen?

3 9 27 81 __

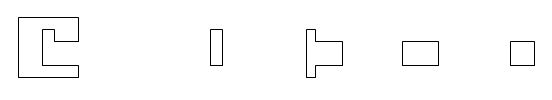

Beispiel einer figuralen (räumlichen) Testaufgabe:

Streichen Sie das Teil oder die Teile, die ohne Überlappung die Lücke in der Figur links ausfüllen:

In Abhängigkeit vom Frageinhalt spricht man von verbaler, numerischer oder figuraler (räumlicher) Intelligenz. Manche Intelligenztests bestehen aus einer Mischung dieser Aufgabenarten und das Durchschnittsergebnis wird oft als ein Maß des IQs gedeutet (wird in der Forschung oft auch „g“ oder „GMA“ (General Mental Ability) genannt). Einige Tests wurden dafür entwickelt, den Kern des Intelligenzbegriffes direkter zu messen. Diese Tests sind oft figural und vom Matrizentypus (wie der Raven-Test). Als ein Vorteil dieser Tests wird hervorgehoben, dass das Ergebnis nicht so stark vom Ausbildungsniveau und von sonstigen Umweltfaktoren der Testpersonen beeinflusst wird. Solche Tests sind verhältnismäßig „culture-fair“ und man kann auch international die gleichen Vergleichswerte (Normwerte) verwenden. Der Psytest-Test „g-fair“ ist eine Variante eines solchen Tests.

Kreativitätstests

Es gibt auch Problemlösetests, die nicht immer mit dem Begriff „Intelligenz“ im engeren Sinne verknüpft werden. Hier sind die Kreativitätstests einzuordnen. Oft wird die Menge an Ideen festgehalten, die in einer bestimmten Zeit produziert werden können und manchmal sogar deren Originalität beurteilt. Ein Beispiel eines solchen Tests: „Eine Gabel wird in der Regel zum Essen benutzt, aber wozu kann sie auch verwendet werden? Schreiben Sie so viele ungewöhnliche Anwendungsmöglichkeiten für eine Gabel auf, wie Ihnen einfallen. Sie haben dafür zwei Minuten Zeit.“

Geschwindigkeits- und Konzentrationstests

Eine andere Art von Eignungstests, die nur manchmal mit dem Intelligenzkonzept in Verbindung gebracht werden, sind die sog. Geschwindigkeits- und Konzentrationstests. Diese Tests bestehen im Allgemeinen aus sehr vielen sehr einfachen Aufgaben, die möglichst schnell und genau gelöst werden sollen. Beispiel: Streichen Sie alle Zahlen größer als 3 in der folgenden Serie durch: 3 4 1 1 7 8 3 5 6 2 2 9 4 3 7 7 … usw.

Gedächtnistests

Tests zur Messung von Gedächtnisfunktionen (in der Regel Funktionen des Kurzzeitgedächtnisses) sind recht oft Teil größerer Intelligenztestbatterien. Oft sollen sich die Testpersonen Wörter, Zahlen oder Figuren einprägen, wobei sie nach einer Weile Fragen dazu gestellt bekommen. Zum Beispiel können ihnen zunächst Wortkombinationen wie Mantel – Stuhl, schwer – Licht, Bewegung – Graben vorgelegt werden. Dann bekommen die Testpersonen nur das erste Wort vorgegeben und sollen sich an das assoziierte Wort erinnern.

Die Entwicklung der Intelligenztests

Sir Francis Galton (1822–1911)

Wenn man nach der Quelle irgendeines Aspekts der differentiellen Psychologie sucht (der Psychologie, die die Unterschiede zwischen Menschen untersucht), landet man stets bei Galton.

Sir Francis Galton war Halbcousin von Charles Darwin (ihr gemeinsamer Großvater Erasmus Darwin wurde Witwer und heiratete nochmals). Galton begründete die Psychometrie, er entwickelte das Konzept der Normalverteilung und prägte die Begriffe „Regression“ und „Korrelationskoeffizient“. Seine Ansätze wurden von bekannten Nachfolgern wie Karl Pearson weiterentwickelt. Galton war (von Darwin inspiriert) sehr an Vererbungsprinzipien interessiert und führte mit ambitiöser Verbesserungsabsicht den Ansatz und den Begriff „Eugenik“ ein. Als Hilfsmittel für seine Untersuchungen entwickelte er die ersten standardisierten Tests. Sie sollten einen generellen Begabungsfaktor messen, d.h. einen Faktor der etwa dem heutigen g-Faktor entspricht. Die angewendeten Methoden zielten auf das Messen der Schärfe der Sinne (wie des visuellen Diskriminierungsvermögen) oder einfacherer motorischer Aspekte (wie der Reaktionsgeschwindigkeit) ab, also auf eine „saubere“ Messung von „schmalen“ Fähigkeiten, die alle die generelle Begabung bestimmen sollten.

Sir Francis Galton war Halbcousin von Charles Darwin (ihr gemeinsamer Großvater Erasmus Darwin wurde Witwer und heiratete nochmals). Galton begründete die Psychometrie, er entwickelte das Konzept der Normalverteilung und prägte die Begriffe „Regression“ und „Korrelationskoeffizient“. Seine Ansätze wurden von bekannten Nachfolgern wie Karl Pearson weiterentwickelt. Galton war (von Darwin inspiriert) sehr an Vererbungsprinzipien interessiert und führte mit ambitiöser Verbesserungsabsicht den Ansatz und den Begriff „Eugenik“ ein. Als Hilfsmittel für seine Untersuchungen entwickelte er die ersten standardisierten Tests. Sie sollten einen generellen Begabungsfaktor messen, d.h. einen Faktor der etwa dem heutigen g-Faktor entspricht. Die angewendeten Methoden zielten auf das Messen der Schärfe der Sinne (wie des visuellen Diskriminierungsvermögen) oder einfacherer motorischer Aspekte (wie der Reaktionsgeschwindigkeit) ab, also auf eine „saubere“ Messung von „schmalen“ Fähigkeiten, die alle die generelle Begabung bestimmen sollten.

Diese Art von Begabungstests wurde auch später von James McKeen Cattell benutzt. Die frühen Intelligenztests kamen aber nach einer Weile in eine Art Krise, weil die „schmalen“ Messungen nur schwach mit anderen, gängigeren Kriterien der Intelligenz korrelierten (z.B. mit Urteilen von Lehrern über die Intelligenz ihrer Schüler). Es gab aber modernere Forscher wie Eysenck (1985), die diese Art von Messungen „restaurieren“ wollten. Eysenck meinte z.B., dass Maße der Reaktionsgeschwindigkeit durchaus sehr hohe Korrelationen mit allgemein anerkannten (neueren) g-Faktor-Maßen aufzeigen können.

Sonstige Leistungen Galtons sind, dass er die Methode der Identifizierung von Personen durch Fingerabdrücke erfand. Galton entwickelte die Methode transparente Fotos von verschiedenen Personen übereinander zu legen, um Durchschnittstypen herauszuarbeiten. Er entwickelte außerdem einen Assoziationstest, der später von Carl G. Jung benutzt wurde (der aber nichts mit MBTI zu tun hat). Galton schrieb auch damals sehr geschätzte Reisebücher (u.a. über seine Reisen in Afrika).

Für die Akzeptanz und Verbreitung der Intelligenztests spielte der nächste Forscher eine entscheidende Rolle.

Alfred Binet (1857–1911)

Binet suchte nach Methoden zur Beurteilung, welche Schüler auf besondere Unterstützung angewiesen sind, um eine grundlegende Schulausbildung zu absolvieren. Er war ein Kritiker der „schmalen“ Tests und meinte, die Intelligenz ließe sich am besten über komplexe Aufgaben messen, bei deren Lösung Urteilsvermögen, Wirklichkeitssinn, Initiative und Anpassungsvermögen direkter gezeigt werden müssen. Der erste Test von Binet wurde 1905 (Binet & Simon) publiziert. Binet betrachtet die Intelligenz als eine umfassende Fähigkeit, und sein Test, genauer: seine Testbatterie, bestand aus 30 verschiedenen Aufgaben. Er beinhaltete motorische Aufgaben, „Digit Span“, Satzergänzung, Gedächtnistest, verbale Flüssigkeit (divergente Produktion entsprechend Guilford, s. unten) usw.

Binet suchte nach Methoden zur Beurteilung, welche Schüler auf besondere Unterstützung angewiesen sind, um eine grundlegende Schulausbildung zu absolvieren. Er war ein Kritiker der „schmalen“ Tests und meinte, die Intelligenz ließe sich am besten über komplexe Aufgaben messen, bei deren Lösung Urteilsvermögen, Wirklichkeitssinn, Initiative und Anpassungsvermögen direkter gezeigt werden müssen. Der erste Test von Binet wurde 1905 (Binet & Simon) publiziert. Binet betrachtet die Intelligenz als eine umfassende Fähigkeit, und sein Test, genauer: seine Testbatterie, bestand aus 30 verschiedenen Aufgaben. Er beinhaltete motorische Aufgaben, „Digit Span“, Satzergänzung, Gedächtnistest, verbale Flüssigkeit (divergente Produktion entsprechend Guilford, s. unten) usw.

Eigentlich stand Binets sehr breite Betrachtung der Intelligenz im Wiederspruch dazu, dass er (nur) ein einziges Maß der Intelligenz ausrechnete. Sein Forschungseinsatz war aber aus klarem Handlungsbedarf entstanden (und wurde vom französischen Staat bezahlt), und aus praktischen Gründen war ein einheitliches Maß zu bevorzugen. Binets Test wurde schon früh revidiert: 1908 und 1911. Eine stark überarbeitete Version von 1916 war der Stanford-Binet-Test von L. M. Terman. Dieser Test wiederum wurde in den Jahren 1937, 1960, 1972 und 1986/87 revidiert. Er wird immer noch benutzt und ist weit verbreitet.

Charles Spearman (1863–1945)

Spearman prägte den Begriff „g-Faktor der Intelligenz“. Er war von Galton beeinflusst und betrachtete die Intelligenz als ein einheitliches Konstrukt. Aber ähnlich wie Binet benutzte er bei der Messung komplexe Aufgaben, die bis heute zeitgemäß wirken. Spearman war theoretisch stringent und entwickelte auch eine eigene statistische Untersuchungsmethode: Seine Tetrad-Analyse ist eine Vorgängerin der heute weit verbreiteten Faktorenanalyse.

Spearman prägte den Begriff „g-Faktor der Intelligenz“. Er war von Galton beeinflusst und betrachtete die Intelligenz als ein einheitliches Konstrukt. Aber ähnlich wie Binet benutzte er bei der Messung komplexe Aufgaben, die bis heute zeitgemäß wirken. Spearman war theoretisch stringent und entwickelte auch eine eigene statistische Untersuchungsmethode: Seine Tetrad-Analyse ist eine Vorgängerin der heute weit verbreiteten Faktorenanalyse.

Mit Hilfe seiner Tetrad-Analyse konnte Spearman (1904) zeigen, dass bei der Lösung von im Prinzip allen Problemlöseaufgaben der sog. g-Faktor (Generalfaktor) als allgemeiner Intelligenzfaktor mitwirkt. Spearman postulierte im Rahmen seiner Zwei-Faktoren-Theorie, dass der Grad des Erfolgs bei der Lösung einer gewissen Aufgabe einerseits von der Ausprägung des g-Faktors abhängt, andererseits von der Ausprägung eines für die jeweilige Aufgabe spezifischen Faktors (s-Faktor).

Spearman schrieb aber schon 1927 explizit über Gruppenfaktoren, von denen er meint, dass sie eine Zwischenstellung zwischen dem generellen Faktor und den spezifischen Faktoren einnehmen können. Er hielt diese Gruppenfaktoren für sehr selten. In einem (postum herausgegebenen) Buch von 1950 sprach er den Gruppenfaktoren aber eine größere Bedeutung zu. Der Zwist mit Thurstone (s. nächster Abschnitt) wurde wohl auch deshalb tiefer, wobei in diesem Zusammenhang besonders zu berücksichtigen ist, dass Thurstone später einen generellen Faktor akzeptierte.

Louis Leon Thurstone (1887–1955)

Es sind immer noch viele Tests auf dem Markt, die für die Messung von Thurstones Primary Mental Abilities (PMA) konstruiert wurden. Thurstone fokussierte auf die Gruppenfaktorenebene (d.h. Spearmans mittleres Niveau) und meinte anfänglich, diese Gruppenfaktoren wären im Prinzip voneinander unabhängig (nicht korrelierend). So verhält es sich aber nicht, sondern die Faktoren korrelieren normalerweise deutlich miteinander, so dass ein generellerer Faktor angenommen werden muss.

Es sind immer noch viele Tests auf dem Markt, die für die Messung von Thurstones Primary Mental Abilities (PMA) konstruiert wurden. Thurstone fokussierte auf die Gruppenfaktorenebene (d.h. Spearmans mittleres Niveau) und meinte anfänglich, diese Gruppenfaktoren wären im Prinzip voneinander unabhängig (nicht korrelierend). So verhält es sich aber nicht, sondern die Faktoren korrelieren normalerweise deutlich miteinander, so dass ein generellerer Faktor angenommen werden muss.

Die Gruppenfaktoren existieren aber auch. Die besonders gut Belegten sind: V: Verbal Comprehension (Sprachverständnis, verbale Analogien, verbales Schlussfolgern usw.), W: Word Fluency (Reime, Anzahl genannter Wörter aus einer bestimmten Kategorie), N: Numbers (einfache mathematische Berechnungen unter Zeitdruck), S: Space (Lage und Beziehung von Körpern, räumliches Auffassungsvermögen), M: Associative Memory (Gedächtnis für paarweise assoziierte Wörter), P: Perceptual Speed (Geschwindigkeit und Genauigkeit bei der Lösung „einfacher“ Aufgaben), I (oder R): Induction (oder General Reasoning) (vor allem induktives, aber auch deduktives Schlussfolgern).

Joy Paul Guilford (1897–1988)

Guilford ist auch bei den Persönlichkeitstheoretikern vorgestellt worden, aber er ist eigentlich besonders für sein Structure of Intellect Model bekannt. Dieses weicht recht deutlich vom Mainstream in der Intelligenzforschung ab und zwar insofern als es die Existenz eines g-Faktors verleugnet und durch seinen sehr hohen Differenzierungsgrad.

Guilford ist auch bei den Persönlichkeitstheoretikern vorgestellt worden, aber er ist eigentlich besonders für sein Structure of Intellect Model bekannt. Dieses weicht recht deutlich vom Mainstream in der Intelligenzforschung ab und zwar insofern als es die Existenz eines g-Faktors verleugnet und durch seinen sehr hohen Differenzierungsgrad.

Ausgehend von theoretischen Überlegungen nimmt Guilford drei breite Dimensionen an, nach denen sich intellektuelle Fähigkeiten einteilen lassen. Diese sind Operationen mit der Untereinteilung: Kognition, Gedächtnis – Einprägen, Gedächtnis – Wiedergabe, divergente Produktion, konvergente Produktion und Evaluation. Inhalt: Visueller, auditorischer, symbolischer, semantischer und verhältnismäßiger. Produkte: Einheiten, Klassen, Relationen, System, Transformationen und Implikationen. Daraus ergeben sich 6x5x6 Kategorien, die wiederum 180 mögliche Kombinationen ergeben, d.h. 180 Zellen in Guilfords kubenähnlichem SI-Modell. Jede Zelle soll einem Intelligenzfaktor entsprechen.

Im Rahmen eines umfassenden Forschungsprojekts meinen Guilford (1967) und Guilford & Hoepfner (1971), 98 der 180 postulierten Faktoren identifiziert zu haben. Guilfords SI-Modell wurde aber von anderen Forschern stark kritisiert. Sie (z.B. Cattell, 1987; Eysenck, 1985; Kline, 1999) sagten alle in etwa das Gleiche: Die faktorenanalytische Methode von Guilford und Kollegen hätte jede beliebige Intelligenzstruktur bestätigen können und die mit anderen Techniken gewonnene empirische Datenstruktur könne bedeutend besser durch andere Modelle erklärt werden.

Beliebt geblieben ist aber Guilfords Unterscheidung zwischen divergenter und konvergenter Produktion: Bei der divergenten Produktion soll man sich ausgehend von einem Stimulus möglichst viele unterschiedliche Alternativen ausdenken (z.B. innerhalb von 2 Minuten möglichst viele Wörter, die mit T anfangen und mit A enden), während man bei der konvergenten Produktion die einzige richtige Antwort herausfinden soll (z.B. „Auge“ ist zu „sehen“ wie „Ohr“ zu ______ ). Aufgaben der Messung von konvergenter Produktion ähneln vielen Intelligenztestaufgaben, während divergente Produktion oft mit Kreativität in Verbindung gebracht wird.

Raymond B. Cattell (1905–1998)

Wie Guilford ist Cattell schon unter den Persönlichkeitstheoretikern vorgestellt worden, hat aber auch einen Platz unter den Intelligenzforschern. Dies hängt mit seiner Theorie der fluiden und kristallinen Intelligenz zusammen, die er mit J. L. Horn entwickelte. Nach Cattell (der als junger Forscher eine Weile Spearmans Assistent war) sollte der g-Faktor geteilt betrachtet werden: Mit fluider Intelligenz meint Cattell den biologisch festgelegten Teil der Intelligenz (etwa bestimmt durch die Masse der Hirnrinde). Mit kristallisierter Intelligenz meint Cattell den Anteil der Intelligenz, der durch Ausbildung und Erfahrung bestimmt wird. Eine Art von Software-Intelligenz also, während fluide Intelligenz eine Hardware-Intelligenz wäre, nicht zuletzt dem Arbeitsspeicher des Computers ähnlich.

Wie Guilford ist Cattell schon unter den Persönlichkeitstheoretikern vorgestellt worden, hat aber auch einen Platz unter den Intelligenzforschern. Dies hängt mit seiner Theorie der fluiden und kristallinen Intelligenz zusammen, die er mit J. L. Horn entwickelte. Nach Cattell (der als junger Forscher eine Weile Spearmans Assistent war) sollte der g-Faktor geteilt betrachtet werden: Mit fluider Intelligenz meint Cattell den biologisch festgelegten Teil der Intelligenz (etwa bestimmt durch die Masse der Hirnrinde). Mit kristallisierter Intelligenz meint Cattell den Anteil der Intelligenz, der durch Ausbildung und Erfahrung bestimmt wird. Eine Art von Software-Intelligenz also, während fluide Intelligenz eine Hardware-Intelligenz wäre, nicht zuletzt dem Arbeitsspeicher des Computers ähnlich.

Cattells Konzept von der kristallinen und fluiden Intelligenz scheinen in der Wissenschaftswelt gut akzeptiert. Unter anderem Carrolls (1993) umfassende Forschungen unterstützten die Cattells Theorie zumindest teilweise. Mit A. R. Hakistian erforschte Cattell auch die Primärfaktoren der Intelligenz neu. Cattell konstruierte schon in den 1930er Jahren Tests zur Messung der fluiden Intelligenz. Diese Tests sind „culture-fair“ und haben den Vorteil, sprachunabhängig und relativ kulturunabhängig zu sein. Personen aus unterschiedlichen Kulturen und Ländern können mit denselben Tests unter Benutzung derselben Normwerte getestet werden.